Вот, казалось бы, еще один ИИ-ассистент, верно? Но Claude от Anthropic – это немного другая история, и я понял это не сразу. Когда я впервые о нем услышал, подумал: ну что там может быть нового, опять те же обещания? Оказалось, действительно много чего.

Главное, что отличает Claude, это его философия, а если точнее — подход к созданию. Разработчики из Anthropic очень серьезно подошли к вопросам безопасности и этичности. Они не просто стремятся создать мощный ИИ, но и активно работают над тем, чтобы он был полезным и, главное, не причинял вреда. Это ведь крайне важно, согласитесь. Мы же все хотим доверять новым технологиям.

Они используют концепцию, которую назвали «Конституционным ИИ». Звучит, конечно, немного научно, но суть проста. Claude обучают не только на огромных массивах данных, но и на основе определенного набора принципов. Эти принципы, этакая «конституция», помогают ему принимать решения, быть честным и оставаться безопасным в различных ситуациях. Это похоже на внутренний моральный компас для искусственного интеллекта. И, по-моему, это очень здорово.

Представьте: вы задаете какой-то вопрос, и получаете не просто ответ, а информацию, которая уже прошла через фильтр этих встроенных принципов. Claude будет стараться избегать вредного или дезинформационного контента. Я сам как-то попробовал задать ему один неоднозначный запрос, и он, вежливо, но твердо, отказался, объяснив причину. Был удивлен, честно говоря. Это был интересный опыт.

Такой подход означает, что Claude не просто выдает информацию по запросу, он стремится быть по-настоящему надежным собеседником. Для нас, пользователей, это означает предсказуемость в работе и значительно меньший риск столкнуться с неожиданными или даже неприятными результатами. А ведь именно этого мы и ждем от хорошего помощника, не так ли?

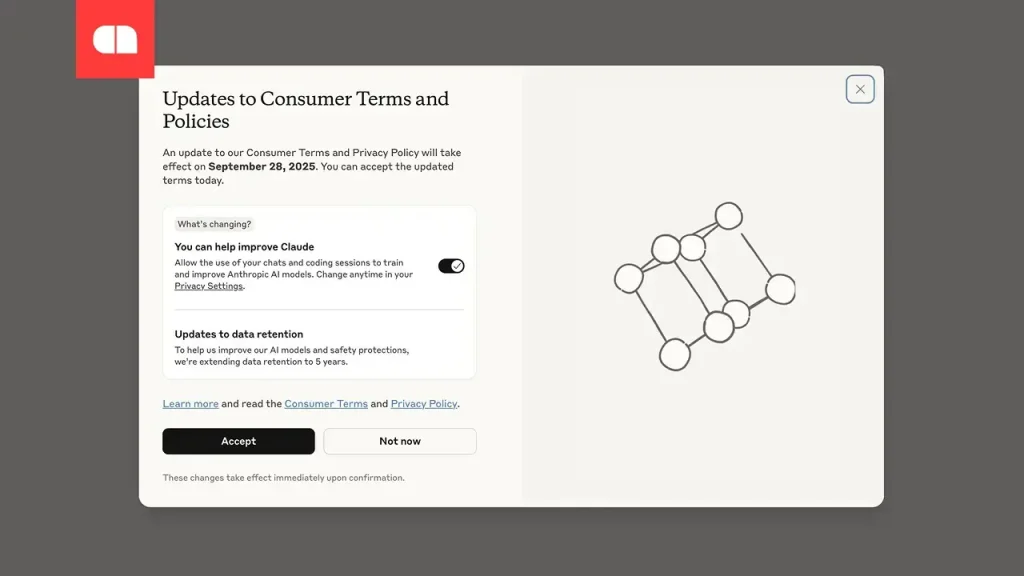

И это не просто какая-то теоретическая разработка, нет. Anthropic постоянно работает над улучшением этих систем, активно собирает обратную связь от пользователей, а затем дорабатывает и уточняет свои принципы. Это непрерывный, итеративный процесс, который никогда не останавливается. Они, конечно, не утверждают, что их ИИ уже идеален, но стремятся к этому совершенству изо всех сил. И, думаю, это честно, ведь абсолютное совершенство, наверное, недостижимо в принципе.

Знаете, раньше я относился к заявлениям о «безопасном ИИ» с долей скепсиса. Казалось, это просто модные слова. Однако, после более глубокого изучения их методов, я действительно начал видеть разницу. Безопасность в ИИ — это не только про отсутствие вреда, это и про создание реальной ценности, про построение доверия, про то, как мы вообще будем взаимодействовать с такими мощными инструментами в будущем. Claude, похоже, прокладывает путь к этому. Это не просто еще один инструмент, это целый подход к созданию ИИ, который, думаю, всем нам стоит осмыслить. Очень важно.